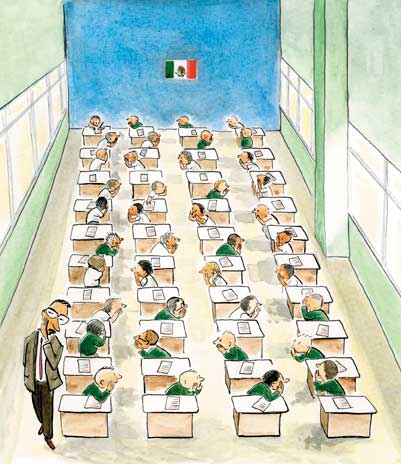

Las pruebas estandarizadas de rendimiento académico, que se utilizan para evaluar la calidad y progreso educativos de un país, tomar decisiones de política educativa y rendir cuentas a la sociedad, inician a nivel mundial en los años sesenta del siglo pasado.

Este artículo está disponible sólo para suscriptores

Si ya tienes una suscripción puedes iniciar sesión aquí.

Suscríbete

Suscripción plus

(impresa y digital)

1 año por $ 799 MXN

Entrega de la edición impresa*

Lectura de la versión impresa en línea

Acceso ilimitado al archivo

Contenidos especiales

*Para envíos internacionales aplica un cargo extra, la tarifa se actualizará al seleccionar la dirección de envío

Suscripción digital

1 año por $ 399 MXN

Lectura de la versión impresa en línea

Acceso ilimitado al archivo

Contenidos especiales

¿Eres suscriptor de la revista y aún no tienes tu nuevo registro?

Para obtenerlo, sólo tienes que validar tus datos o escribe a soporte@nexos.com.mx.